日前,在刚刚举行的2023云栖大会上,百川智能创始人王小川畅谈大模型时代,复旦特聘教授漆远借助复旦大学智能计算平台CFFF引出人工智能推动科研范式变革,也有基于AIGC能力的儿童故事产品带来分享。

当一场云计算大会由AI相关内容占据主论坛的半壁江山,或许已经说明了“计算”风向:AI正在成为不可忽视的计算主角。

AIGC将有更多爆发 2024年是大模型商业化元年

过去十来年,云计算不断发展、应用,服务了社会数字化进程。今天,随着大模型技术的迅速发展,智能化时代正在开启。人工智能将成为各行各业的新型生产力,以ChatGPT为代表的大模型应用仅仅是一个开始。

今年以来,众多大模型产品发布,基于大模型的AIGC技术在文本生成、知识回答、图像生成、逻辑推理等方面表现出远超预期的效果,吸引了大量用户与市场关注。

以生产力视角看,AIGC具备多方面优势,第一是大幅度节省人力和时间成本,很多东西可以秒级生成;第二是比较大幅度改善内容质量,经过训练后输出的内容质量超过95%以上人力的智能。

国内推出的过百个大模型以基础大模型为主,多停留在对话、图像生成用途,AIGC的第三点优势尚不能体现,即如同曾经云计算带来的数字化变革一般,将有助于众多产业、行业的数字化,将为数字经济建设发挥重要作用。

因此,行业认为当下的AIGC火爆只是刚刚开始,后续还将迎来更多爆发。

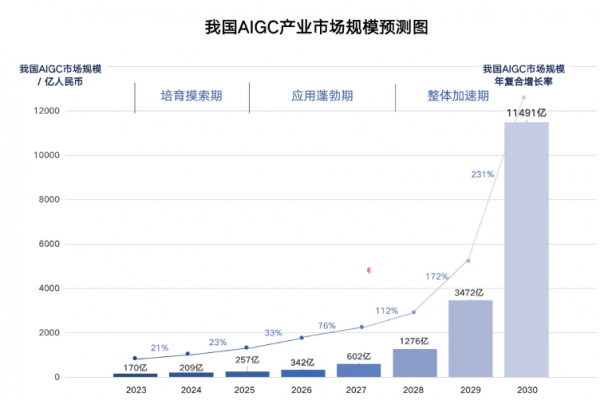

图源《中国AIGC产业全景报告暨AIGC 50》

《中国AIGC产业全景报告暨AIGC 50》显示,预计2023年我国市场规模可达170亿人民币,AIGC企业在业务场景变现还处于探索验证时期。而后随着产业加速增长,商业化落地逐渐深入、产业生态逐步完善,分别来到应用蓬勃期(2025-2027)和整体加速期(2028-2030),2030年市场规模将超万亿人民币,产业链、价值链和业务链完全整合在一起。

在AIGC产品百花齐放的同时,变现是大模型厂商们接下来必须要考虑的问题。

目前大模型的营收方式主要有四种:MaaS、按产出内容量付费、软件订阅付费、模型定制开发费。ChatGPT主要依赖软件订阅付费和MaaS收入,其母公司OpenAI的CEO近日透露公司年化营收达13亿美元(折合人民币近95亿)。

国内厂商尚在进行商业模式的探索,是参考ChatGPT还是绑定其他业务赚钱,大模型的营收变现有待进一步明确。有AI芯片企业负责人表示,今年下半年开始,商业模式如何赚钱将成为大模型厂商的必答题。

他认为,2024年将是大模型商业化的元年,也是关键一年。

智算需求只增不减 明年迎海量部署消耗

看得见的AIGC蓬勃发展背后,是看不见的智能算力在支撑。

大模型爆发掀起了新一轮AI热潮,也改变了智能算力需求与格局。

众所周知,AI要经过训练与推理两个步骤,训练即模型产生的过程,推理即模型部署的过程。大模型从业者向笔者表示,大模型出来后则分成了三个阶段:首先预训练,然后微调——把大模型垂直化,最后是推理部署。

“现在预训练的过程中,大家都是堆卡、堆集群,动不动烧几千万上亿训练大模型。微调阶段就已经进入了行业化,做推理的时候已经进入了商业部署,这两个阶段怎样真正赚钱而不是像预训练那样烧钱就变得非常重要。行业化和商业化的关键在于性价比,如何能够真正大规模部署AI应用,能不能通过底部支撑的算力系统集成部署打造极致性价比?”

产业专家指出,总体来看,大模型所需的智能算力需求将只增不减。今年通用大模型最火,单模型算力需求基本以千P为单位。未来大模型必然要走专业化、行业化的发展方向,形成众多产业大模型,其算力单个需求可能只有几百P,但产业场景越来越多,总量需求将比现有通用大模型的智能算力总需求更大。

智能算力从哪来?智算中心

根据工信部等六部门新政策中的定义,使用大规模异构算力资源,包括通用算力(CPU)和智能算力(GPU、FPGA、ASIC等),主要为人工智能应用——如人工智能深度学习模型开发、模型训练和模型推理等场景,提供所需算力、数据和算法的智算中心,在推进人工智能和数字经济发展中发挥着重要作用。

成都智算中心

大模型需求驱动下,智算中心项目如雨后春笋般涌现。中国信通院云大所副所长栗蔚指出,预计2023年将有超过30个城市在建或者筹建智算的中心。而据中国IDC圈不完全统计,仅在2023年7月到9月,以“智算中心”为名字的项目规划在建及建成的就超过36个,预计总投资规模超过460亿。

有算力领域企业表示,当前一些智算中心建设偏盲目,逻辑是“先建算力,再找需求”。

他判断未来会趋向谨慎,尤其是to G(政府主导)的智算中心建设。2024年国内智算中心建设,一定是先找当地的算力消纳,再根据算力需求再建相关算力匹配。

“2024年大模型会大规模部署、赋能,这一过程中对于算力的消耗是海量的。”

从液冷应用到多云部署 大模型改变数据中心

智能化时代正在开启,AI将成为各行各业的新型生产力,也对算力提出更高的要求。

今天,从大模型服务到底层智能算力再到算力基础设施,都正在面向AI时代进行全面的技术升级和创新。

算力市场分为三个层级,在大模型位于的最上层,面临系统的适配中心、业务迁移耗时、 定制开发的投入等问题。中层的算力平台需要满足支持CPU+GPU的调用、硬件接口的统一、互联协议的标准、软件生态的兼容性等要求。在最下层,即智算中心这一基础设施层,主要解决大算力背景下的高电能散热问题。

此前数据中心以普通CPU服务器为主,AI大模型训练和推理运算使用GPU服务器,单台设备的额定功率最高达12千瓦以上,远超CPU功率水平。当前数据中心单机柜功率以6kw、8kw为主,4KW亦不少见,未来智算中心单机柜功率可能十几千瓦,几十千瓦,单体智算中心可能上百兆瓦。

高功耗带来高热量,原有风冷很难满足GPU散热需求,液冷成为更好的解决方案。除散热效率更高外,占地面积低、绿色节能也是液冷的优势。今年以来,液冷在数据中心的应用部署量已经显著上升。

当单个计算中心的算力无法满足大模型的巨大算力需求,需要将多个算力中心连接起来,共同为大模型提供训练的相关能力,同时巨大算力消耗又带来高能源消耗。

因此,单机柜高功率、高效散热、低PUE、多云间的互联、满足云架构的部署,都是大模型发展对智能算力与智算中心提出诸多新要求。

此外,大模型训练与推理场景的不同,生物医疗、图像识别等不同应用对算力精度的不同需求,也影响着智算的布局与算力配置。

更多内容,将在IDCC2023上带来分享与讨论!

第十八届中国IDC产业年度盛典(IDCC2023)将于2023年12月12-14日在北京国家会议中心隆重举行,大会主题为“算力进化 数字开物”,聚焦算力产业热点话题,汇聚业内精英人士,共同探讨数字经济的发展方向和未来趋势。欢迎报名,现场参与!